Üretken Yapay Zeka (LLM): Geleceğin Teknolojisi

Günümüzde yapay zeka teknolojileri, hayatın her alanında hızlı bir şekilde yaygınlaşarak iş süreçlerini ve günlük yaşamı dönüştürmektedir. Bu teknolojiler arasında üretken yapay zeka (Generative AI), yeni içerikler oluşturma kapasitesiyle dikkat çekmekte ve özellikle enerji sektörü gibi karmaşık alanlarda yenilikçi çözümler sunmaktadır. Üretken yapay zeka, sadece metin üretiminde değil, görsel, ses ve veri analitiği gibi pek çok alanda uygulanabilir yetenekleri ile dijitalleşmenin itici gücü haline gelmiştir.

- 27 Ocak 2025 15:31

Akademisyen Dr. Ezgi Avcı

Üretken Yapay Zeka (Generati ve AI), metin, görüntü, ses ve diğer veri türlerinde yeni içerik üretme yeteneğine sahip olan yapay zeka teknolojileridir. Bu teknoloji, genellikle “Büyük Dil Modelleri” (Large Language Models, LLM) olarak bilinen, derin öğrenme algoritmalarını temel alan sistemler üzerinden çalışır. İnsan dilini anlamak, bağlamını kavramak ve yaratıcı içerikler oluşturmak için büyük veri setlerinden öğrenim görür. Üretken yapay zekanın temel amacı, insanların bilgi üretme, analiz etme ve yaratıcı düşünme süreçlerini desteklemek veya otomatikleştirmektir.

ÜRETKEN YAPAY ZEKANIN ÇIKIŞ NOKTASI

Üretken yapay zekanın ortaya çıkışı, yapay zeka alanındaki önemli kilometre taşlarına dayanmaktadır. Bu teknoloji, bilgisayarların dil anlayışını ve üretim yeteneklerini artırma çabalarının bir sonucudur.

1. Turing Testi (1950): Alan Turing’in, bir makinenin insan gibi düşünebileceğini kanıtlamayı amaçlayan bu testi, üretken yapay zekanın temellerini atan düşünsel bir başlangıç noktasıdır.

2. Doğal Dil İşleme (1950’ler – 1980’ler): Doğal Dil İşleme (NLP), bilgisayarların insan dilini anlaması ve üretmesi üzerine yapılan erken çalışmalarla gelişti. ELIZA (1960’lar) gibi ilk chatbotlar, dilin temel kurallarını anlamaya çalışsa da bağlam ve anlam konusunda sınırlıydı.

3. Sinir Ağlarının Yükselişi (1980’ler – 1990’lar): Yapay sinir ağlarının geliştirilmesi, dil işleme modellerinde doğruluğu artırdı. Ancak veri ve hesaplama gücündeki kısıtlamalar, daha karmaşık modellerin geliştirilmesini engelledi.

Tarihsel Süreç ve Gelişmeler

Üretken yapay zeka teknolojisinin bugünkü haline gelmesi, 2010’lu yıllarda yaşanan önemli gelişmelerin bir sonucudur.

2000’ler: Dil Modelleme ve Word2Vec

Doğal dil işleme alanında büyük ilerlemeler, “Word2Vec” gibi kelime gömme (word embedding) teknikleriyle başladı. Bu yöntemler, kelimelerin matematiksel temsillerini oluşturarak dilin bağlamını anlamada önemli bir adım attı. Ancak, bu modeller bağlamı sadece sınırlı ölçüde anlayabiliyor ve uzun metinlerde bağlamı kaybediyordu.

2017: Transformer Modelinin Ortaya Çıkışı

Transformer mimarisi, üretken yapay zekanın dönüm noktasıdır. Google tarafından yayınlanan Attenti on is All You Need adlı makale, dil modellerinin bağlamı anlamasında devrim yaratmıştır. Transformer mimarisi, “attention” mekanizması sayesinde kelimeler arasındaki bağlam ilişkilerini daha etkili bir şekilde öğrenebildi.

- Self-Attention: Her bir kelimenin diğer kelimelerle olan bağını analiz ederek daha derin bir bağlam analizi yapar.

- Paralel İşleme: Verilerin paralel olarak işlenmesi, modellerin daha büyük veri setleriyle eğitilmesini ve hızlı çalışmasını sağladı.

2018: GPT Modelleri

OpenAI’nin GPT (Generati ve Pre-trained Transformer) modelleri, üretken yapay zekanın gelişiminde çığır açan bir seri olmuştur. Bu modeller, önceden eğitilmiş dil modellerinin dil anlama ve üretim yeteneklerini sergileyerek doğal dil işleme (NLP) alanında büyük yenilikler getirmiştir. Her bir yeni versiyon, modelin kapasitesini ve becerilerini önemli ölçüde artırmıştır.

GPT Serisi Modelleri

GPT-1 (2018): OpenAI’nin GPT serisinin ilk modeli olan GPT-1, temel bir dil modelleme kapasitesi sunuyordu. Transformer mimarisini kullanan model, daha önceki doğal dil işleme yöntemlerinden farklı olarak bağlamı daha iyi anlamayı başardı. Ancak, kapasitesi ve parametre sayısı sınırlıydı.

GPT-2 (2019): GPT-2, GPT-1’den çok daha büyük bir parametre seti ne (1,5 milyar parametre) sahipti ve dil üretiminde önemli gelişmeler gösterdi. Bu model, tutarlı ve yaratıcı metinler üretebilme yeteneğiyle dikkat çekti. Aynı zamanda, metin tamamlama ve soru yanıtlama gibi görevlerde daha üstün performans sağladı. Ancak, kötüye kullanım potansiyeli nedeniyle tam modeli başlangıçta kamuya açık hale getirilmedi.

GPT-3 (2020): GPT-3, 175 milyar parametrelik devasa bir yapı ile doğal dil üretimi ve anlama yeteneklerinde bir devrim yarattı . Dil modellerinde gelinen bu aşama, GPT-3’ü yalnızca bir dil modeli değil, çok yönlü bir yapay zeka aracı haline getirdi.

Özellikleri: Farklı görevlerde (metin yazma, özetleme, çeviri, kod üretimi) başarılı performans.

İnsan benzeri etkileşim sağlayabilme.

Daha fazla bağlam bilgisi tutabilme (uzun metinlerde tutarlılığı koruma).

GPT-4 ve GPT-4o (2023): OpenAI’nin GPT-4 modeli, önceki modellerin başarısını bir adım öteye taşımış, çok modelli bir yapıya sahip olarak yalnızca metin değil, görsel girdiler üzerinde de çalışabilir hale gelmiştir. GPT-4o ise GPT-4’ün daha hızlı ve optimize edilmiş bir versiyonudur.

GPT-4’ün Özellikleri:

Çok Modelli Yetenekler: Hem metin hem de görsel girdileri anlayabilir ve yorumlayabilir. Bu, karmaşık veri türlerini entegre eden uygulamalar için büyük bir avantaj sağlar.

Artırılmış Bağlam Penceresi: GPT-4, uzun metinleri işlerken daha fazla bağlam bilgisi tutabilir. Bu, kitap yazma, kapsamlı raporlar hazırlama gibi görevlerde tutarlılığı artırır.

Daha Doğal Etkileşim: GPT4, insan benzeri etkileşimleri daha akıcı ve tutarlı hale getiren gelişmiş dil anlama ve üretme becerilerine sahiptir.

GPT-4o’nun Özellikleri:

Hız ve Verimlilik: GPT-4o, daha hızlı yanıt süreleri ve düşük maliyetli kullanım sağlayarak özellikle kurumsal uygulamalar için uygun bir seçenek sunar.

Enerji ve Performans Optimizasyonu: GPT-4’ün performansını korurken daha düşük enerji tüketimi sağlar.

GPT-1’den GPT-4’e kadar olan süreçte, bu modeller dil anlama ve üretme becerilerini artırarak sadece metin odaklı çözümler değil, aynı zamanda görsel, ses ve kod üretiminde de devrim yaratmıştır. GPT-4 ve GPT-4o, çok modelli yetenekleri ve verimliliğiyle, üretken yapay zekanın geleceğini şekillendiren en son yeniliklerdir. Bu gelişmeler, sadece yapay zekanın kullanımını genişletmekle kalmaz, aynı zamanda iş dünyasından bireysel kullanıcılara kadar geniş bir kitleye hitap eden inovasyonlara olanak tanır.

NEDEN BU KADAR POPÜLER OLDU?

Büyük Veri ve Artan Hesaplama Gücü:

Günümüzde internet, sosyal medya ve diğer dijital kaynaklardan elde edilen veri miktarı muazzam seviyelere ulaşmıştır. Bu veriler, üretken yapay zekanın eğitilmesi için zengin bir kaynak sağlar. Ayrıca, grafik işleme birimleri (GPU’lar) ve tensör işlem birimleri (TPU’lar) gibi güçlü donanımlar, bu modellerin eğitilmesini hızlandırmıştır.

Transformer ve Büyük Dil Modellerinin Etkinliği:

Transformer mimarisi ve büyük dil modelleri, insan benzeri içerik üretimi yapabilen sistemlerin geliştirilmesine olanak sağlamıştır. Bu modeller, bağlam ve anlam konusunda oldukça başarılıdır.

Yapay Zeka Destekli Uygulamaların Artışı:

ChatGPT, Bard, Claude gibi kullanıcı dostu üretken yapay zeka uygulamaları, bireysel kullanıcıların ve işletmelerin bu teknolojilere erişimini kolaylaştırmıştır. Özellikle iş dünyasında metin yazımı, analiz, müşteri hizmetleri ve içerik oluşturma gibi süreçlerde önemli verimlilik sağlamıştır.

Çok Modelli ve Kapsamlı Kullanım Alanları:

Metin üretiminin yanı sıra görsel, ses ve kod üretimi gibi çok modelli uygulamaların geliştirilebilmesi, üretken yapay zekanın popülerliğini artırmıştır. Örneğin, bir LLM tabanlı model, bir mühendis için teknik rapor yazabilir, aynı zamanda bir grafik tasarımcı için yaratıcı görseller oluşturabilir.

NORMAL YAPAY ZEKADAN FARKI NEDİR?

Geleneksel yapay zeka (YZ) genellikle sınırlı bir görevi yerine getirmek için özel olarak tasarlanmış algoritmaları kullanır. Üretken yapay zeka ile geleneksel YZ arasındaki temel farklar şunlardır:

| Kriter | Geleneksel Yapay Zeka | Üretken Yapay Zeka (LLM) |

| Görev Kapsamı | Dar ve özel bir göreve odaklanır | Geçiş ve genel görevler gerçekleştirilebilir. |

| Veri Kullanımı | Özel veri kümeleri ile çalışır | Büyük veri kümeleriyle eğitilir |

| Sonuç Üretimi | Analiz veya karar çıkarımı yapar | Yeni içerik üretilebilir |

| Etkileşim | Sabit kuralları içerir | İnsan diline benzer bir etkileşim sağlar |

Örneğin, geleneksel YZ bir e-ticaret sitesinde öneri sistemi olarak çalışırken, üretken yapay zeka bu önerilerin nedenlerini insan benzeri bir açıklama ile sunabilir ve hatta ürün açıklamaları yazabilir.

LLM’ler nasıl çalışır ve eğitilir?

YAZININ DEVAMI GELECEK SAYILARDA…

SON HABERLER

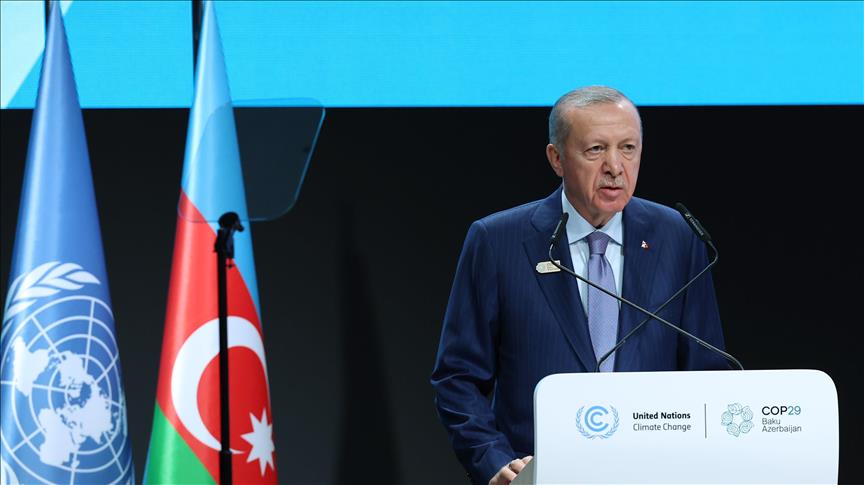

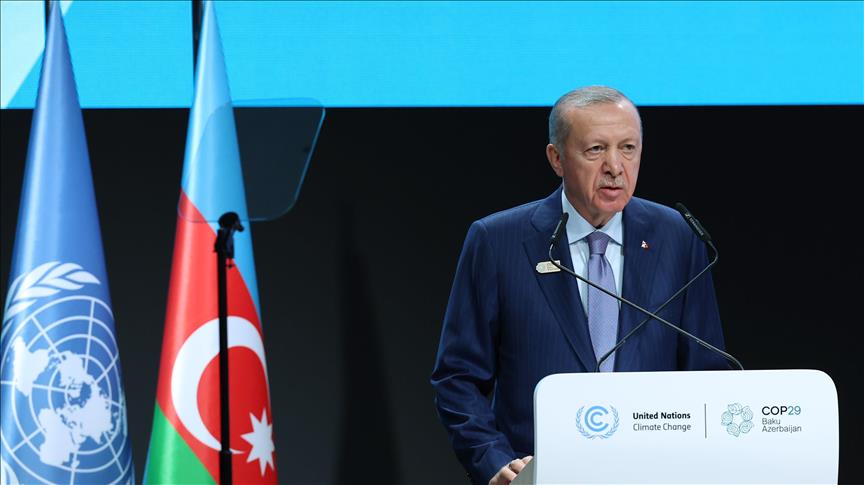

Cumhurbaşkanı Erdoğan, COP29 Dünya Liderleri İklim Zirvesi’nde konuştu12 Kasım 202416:07 Adana’daki iki maden sahası için ihale düzenlenecek12 Kasım 202409:14 Petroleum Istanbul 2025’te ‘Akademi Alanı’ Uluslararası Boyut Kazanıyor21 Nisan 202514:13 TORA, Beko yazarkasalı UTTS sistemleriyle 3300 istasyonda montaj gerçekleştirdi21 Nisan 202513:59 OEDAŞ’ın Can Dostlar projesine uluslararası ödül21 Nisan 202513:36 TSKB “Düşük Karbon Kahramanı” ödülünün sahibi oldu21 Nisan 202513:34 SEDAŞ, Gebze D-100 Karayolu’ndaki aydınlatmaları yeniledi21 Nisan 202513:31

Diğer Haberler